Motivation

Word reordering 是SMT中非常重要的组件。

作者认为可以将 Word Reordering Knowledge 加入到NMT中以增强 attention 机制。

Methods

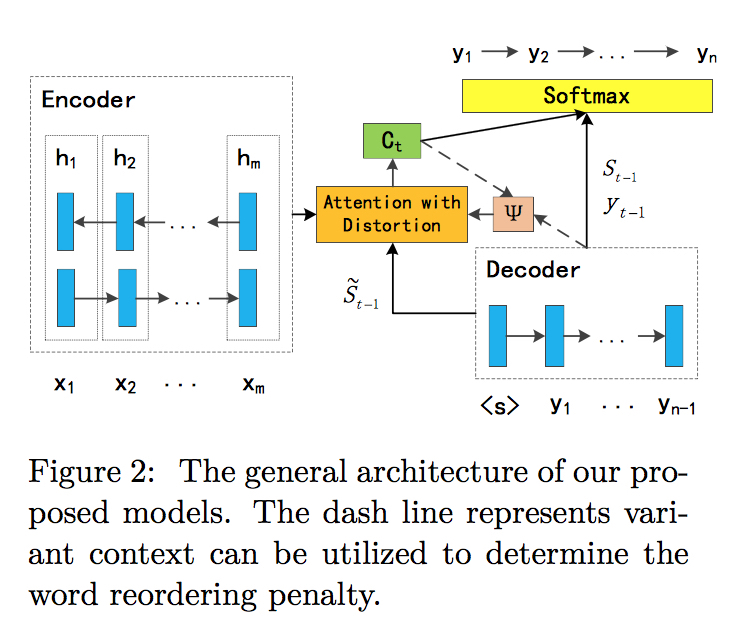

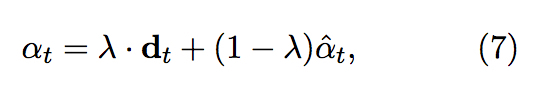

基本想法是在计算 attention 机制中的 $\alpha$ 时,加入考虑 reorder 知识获得的 distort model 计算的 $\textbf{d}_t$

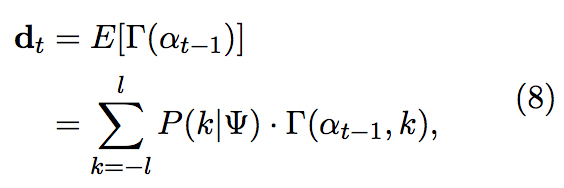

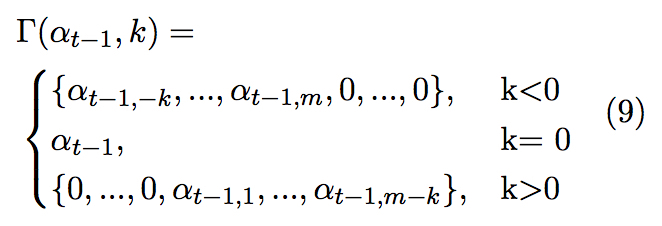

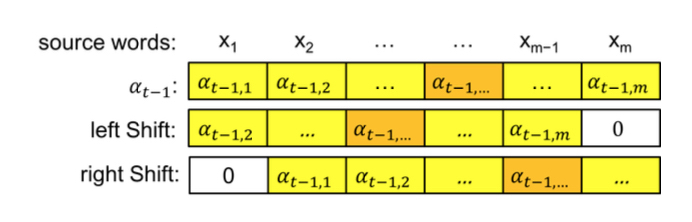

在提出的模型中,$\textbf{d}_t$ 定义为alignment vector $\alpha$ 经过 “shift” 操作得到的所有可能的期望(该期望由context约束),形式化定义如下

这里 k < 0 表示左移,k > 0 表示右移,如下图所示

于是问题的关键转移到了 上下文 $\Phi$ 的表示上,这里的上下文可以是 source, target 或是 hidden states of decoder,分别为提出的三种模型之一

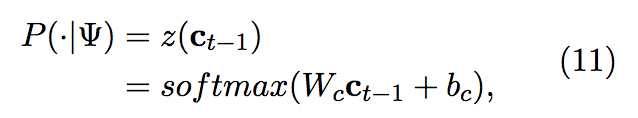

S-Distortion

使用之前的 source 端 context $\textbf{c}_{t-1}$ 作为 $\Phi$,即

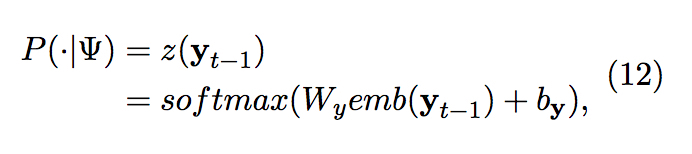

T-Distortion

使用之前的 target 端最新生成的词 $\textbf{y}_{t-1}$ 作为 $\Phi$,即

H-Distortion

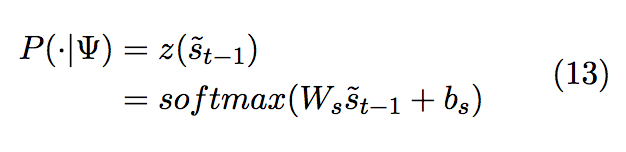

使用之前的 decoder 中隐状态 $\tilde{s}_{t-1}$ 作为 $\Phi$,即